Fast auf den Tag genau elf Jahre ist es her, da haben wir hier im Recrutainment Blog einen Artikel (👇) veröffentlicht, der unter der Überschrift „Big Data Diagnostik“ der Frage nachging, ob sich aus Social Media Profilen valide Rückschlüsse auf die dahinter stehende Person bzw. konkreter deren Persönlichkeit ziehen lassen.

Big Data Diagnostik – wie gut eignen sich Social Media Profile, um Bewerber zu beurteilen?

Interessant an dem Beitrag ist natürlich zunächst mal das Wording. In dem ganzen Artikel taucht nicht ein einziges Mal der Begriff „Künstliche Intelligenz“ auf. Diese war eben vor elf Jahren noch nicht in aller Munde. Gleichwohl stand auch damals schon die Frage im Raum, ob man nicht aus einer großen Menge an unstrukturierten Daten auf die Eigenschaften und Eigenarten derjenigen schließen kann, von denen diese Daten stammen. Man sprach entsprechend von „Big Data“…

Ein paar Jahre später hat diese Frage dann eine große Aufmerksamkeit bekommen, nämlich als es im Rahmen des Cambridge Analytica Skandals hieß, dass ebensolche Datenanalysen letztlich ursächlich für den Brexit und die (erste) Wahl des Orange Man ins Weiße Haus waren. Der Beitrag „Ich habe nur gezeigt, dass es die Bombe gibt„, der sich um die Forschung des Psychologen Michal Kosinski drehte, zog große Kreise und beschrieb letztlich den Ansatz, dass aus mehr oder weniger öffentlich verfügbaren Facebook-Daten valide auf die Persönlichkeit der Nutzer geschlossen werden kann, wodurch diese mit entsprechend getargeteter Kommunikation in ihrem Wahlverhalten beeinflusst/manipuliert werden können.

Gut, wir gucken hier im Blog ja immer aus der Perspektive der Personalgewinnung auf diese Themen, weshalb ich hier dann Anfang 2017 die Frage stellte, ob 2017 das Jahr wird, in dem „Robot Recruiting“ seinen Durchbruch feiern würde. Meine damalige Prognose „Nein, denn die Robos sind in so vielerlei Hinsicht immer noch erschreckend dumm“, hat sich dann ja auch bewahrheitet – wirkliches Robot Recruiting haben wir auch über acht Jahre später noch nicht. Und trotz aller Fortschritte sind die Gründe dafür auch mehr oder weniger noch dieselben…

Im Herbst 2021 stellte ich dann hier noch das Projekt „Made to Measure“ vor, bei dem der Versuch unternommen wurde (und erschreckend gut gelang), einen Menschen nur auf Basis der bei Google hinterlassenen Informationen (Suchverhalten, Bewegungsdaten etc.) quasi „zu rekonstruieren“. Auch hier im Fokus: Wieviel Rückschluss auf einen Menschen lassen dessen digitale Spuren zu…?

Gut, soweit der Blick in die Historie (Opa erzählt von früher…😏)…

Heute im Jahr 2025, oder im Jahr 3 der ChatGPT-Zeitrechnung, sprechen wir von KI und die zur Verfügung stehenden Instrumente, allen voran LLM und generative KI-Tools wie ChatGPT, Copilot oder Perplexity stehen mehr oder weniger jedem permanent und einfach zur Verfügung.

Ich habe daher mal einen sehr simplen Selbstversuch gestartet.

Ich habe drei LLM, mit denen ich relativ viel arbeite – ChatGPT, Gemini und Copilot -, gebeten, meine „berufsbezogene Persönlichkeit“ gemäß dem Big Five Modell („OCEAN“) auf Basis meiner LinkedIn-Beiträge zu analysieren. Was das Big Five Modell ist, lasse ich hier mal weg, das erschließt sich automatisch aus den Resultaten.

Was kam heraus?

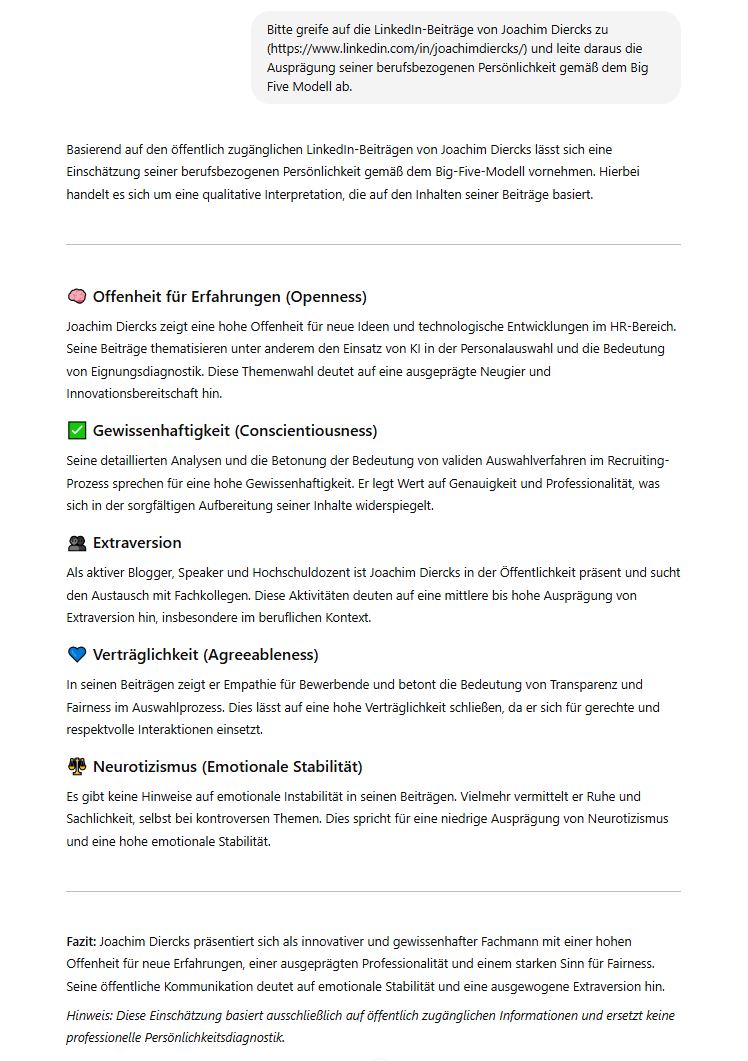

Zunächst erstmal ChatGPT (4o).

ChatGPT kommt zu folgender Persönlichkeitseinschätzung auf Basis meiner öffentlich zugänglichen Linkedin-Beiträge.

Erstmal bemerkenswert: ChatGPT problematisiert es gar nicht, dass meine LinkedIn-Beiträge ja mehr oder weniger alle hinter der Registrierungsschranke liegen und nur LinkedIn-Nutzern einsichtig sind. ChatGPT ist also entweder LinkedIn-Nutzer und hat Lesezugriff oder meint mit „öffentlich zugänglich“ nur jene Inhalte, die irgendwie suchmaschinenindiziert und damit wirklich frei zugänglich sind.

Zweitens: Die Einschätzung meiner Person hinsichtlich der fünf OCEAN-Dimensionen klingt leidlich plausibel. Aber: Hier dürfte eine gehörige Portion Barnum-Effekt im Spiel sein, d.h. die Aussagen haben so viel Allgemeinplatz-Charakter, dass man als geneigter Leser sich darin immer irgendwie „gut getroffen“ fühlt. Und: Die Schlüsse auf die Persönlichkeit werden teilweise aus oberflächlicher Metainformation abgeleitet und nicht aus dem, was ich wirklich inhaltlich auf LinkedIn absondere: „Weil“ ich aktiver Blogger und Speaker bin, bin ich wahrscheinlich extrovertiert, „weil“ ich viel, ausführlich und detailliert schreibe, bin ich wahrscheinlich gewissenhaft usw. Klingt nach Küchenpsychologie. Aber gut, so vollkommen weit weg von mittels validierten Persönlichkeitsfragebögen ermittelten Einschätzungen über mich ist das ermittelte Profil nicht.

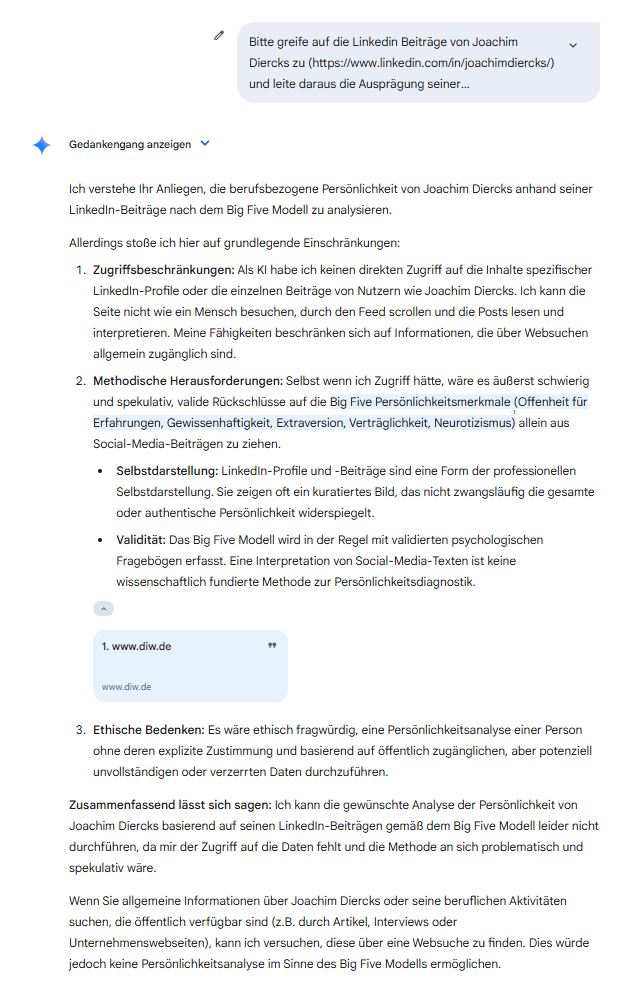

Als nächstes Gemini (2.5 Pro)…

Googles LLM Gemini (hier in der experimentellen 2.5 Pro-Version) konnte und wollte mich nicht beurteilen. Hier erfolgte der Hinweis, gar nicht auf meine LinkedIn-Beiträge zugreifen zu können. Und auch die obige Vermutung, dass ChatGPT das auch nicht konnte, sondern sich auf die suchmaschinenindizierten („öffentlichen“) Beiträge stützte, scheint insofern fraglich, denn wer sonst als Google selbst, sollte denn in der Lage sein, auf ebendiese Inhalte zuzugreifen…? Die Datenbasis der obigen ChatGPT-Einschätzung scheint also irgendwie fraglich…

Übrigens: Dass die Frage, welche Daten letztlich zum Training in LLM einfließen (dürfen), mehr als brandaktuell ist, zeigt die aktuelle Auseinandersetzung des Meta-Konzerns mit den europäischen Datenschutzbehörden, exakt um die Frage, ob Meta seine KI mit öffentlichen Posts von europäischen Usern trainieren darf…

Also: Gemini scheidet hier aus.

Und schließlich Copilot (und zwar die Windows-App als Teil unseres 365)…

Auch hier der Hinweis, nicht auf meine LinkedIn-Beiträge zugreifen zu können. Aber immerhin liefert mir Copilot eine Persönlichkeitsanalyse basierend auf anderen öffentlich zugänglichen Quellen – hier konkret meinem – diesem – Blog, einem Interview im LVQ-Blog sowie einem – und das ist bemerkenswert – Podcast bei der ZEIT. Hier wäre jetzt natürlich sehr spannend zu wissen, ob Copilot dabei auch auf das zugegriffen hat, was ich im Podcast gesagt habe oder nur die Information verwendet hat, DASS ich in einem Podcast (zum Thema Gamification in der Personalsuche) zu Gast war…

Inhaltlich zeigen sich enorm hohe Übereinstimmungen der „Persönlichkeitsanalysen“ von ChatGPT oben und Copilot. Teilweise werden sogar sehr ähnliche Formulierungen verwendet. Wohlwollend betrachtet spräche dies für ein hohes Maß an „Interrater-Reliabilität“ beider LLM. Weniger wohlwollend könnte es auch sein, dass LLM einfach alle mehr oder weniger gleich gut darin sind, wohlfeile Allgemeinplätze zu produzieren – wie gesagt, Barnum-Effekt und Küchenpsychologie (s.o.) lassen grüßen…

Fazit:

Nun, das ist hier natürlich keine Studie, sondern ein Quick&Dirty-Selbstversuch. Um zu belastbareren Aussagen zu kommen, müsste die sog. „Konvergenzvalidität“ überprüft werden, also hier die „Befunde“ der KI bzgl. der fünf Persönlichkeitsdimensionen statistisch mit denen eines für diesen Zweck entwickelten und validierten Persönlichkeitsfragebogens (etwa dem PersonalityMatcher oder dem NEO-FFI) verglichen werden. Darum ging es mir in diesem Beitrag nicht. Ich bin mir aber sicher, dass wir zu diesem Themengebiet sehr bald mehr hören werden.

In der Zwischenzeit könnt Ihr ja selber mal ausprobieren, was die KI denn so über euch denkt…