Ihr kennt das. Seit Jahren arbeiten wir uns hier nun schon am Thema „Künstliche Intelligenz speziell im Kontext der Bewerberauswahl und -beurteilung“ ab.

Die Technologien sind faszinierend, aber auch die damit einhergehenden Probleme beträchtlich. Dabei sind nicht nur ethische Probleme gemeint. Oder Probleme der Akzeptanz (auch und vor allem auf Bewerberseite). Sondern das geht schon bei den methodischen Problemen los:

Kann eine Maschine auf Basis von Stimme, Gestik oder Mimik stabile Personenmerkmale, z.B. Persönlichkeit / Charakter erkennen?

Sagen diese Merkmale überhaupt etwas über Persönlichkeit aus, unabhängig von der Frage, ob die Beurteilung durch Maschine oder Mensch erfolgt?

Und: Selbst wenn die Messung dieser Merkmale gelänge, wie viel ist dadurch für das eigentliche Ziel – die Vorhersage beruflicher Eignung – denn gewonnen?

All diese Fragen haben wir über die letzten Jahre in zahlreichen Artikeln, Interviews und Experimenten versucht, zumindest ein wenig aufzuklären. So führte ein recht simples Experiment mit der Sprachanalyse-Software Precire vor anderthalb Jahren zu teilweise mehr als skurrilen Ergebnissen.

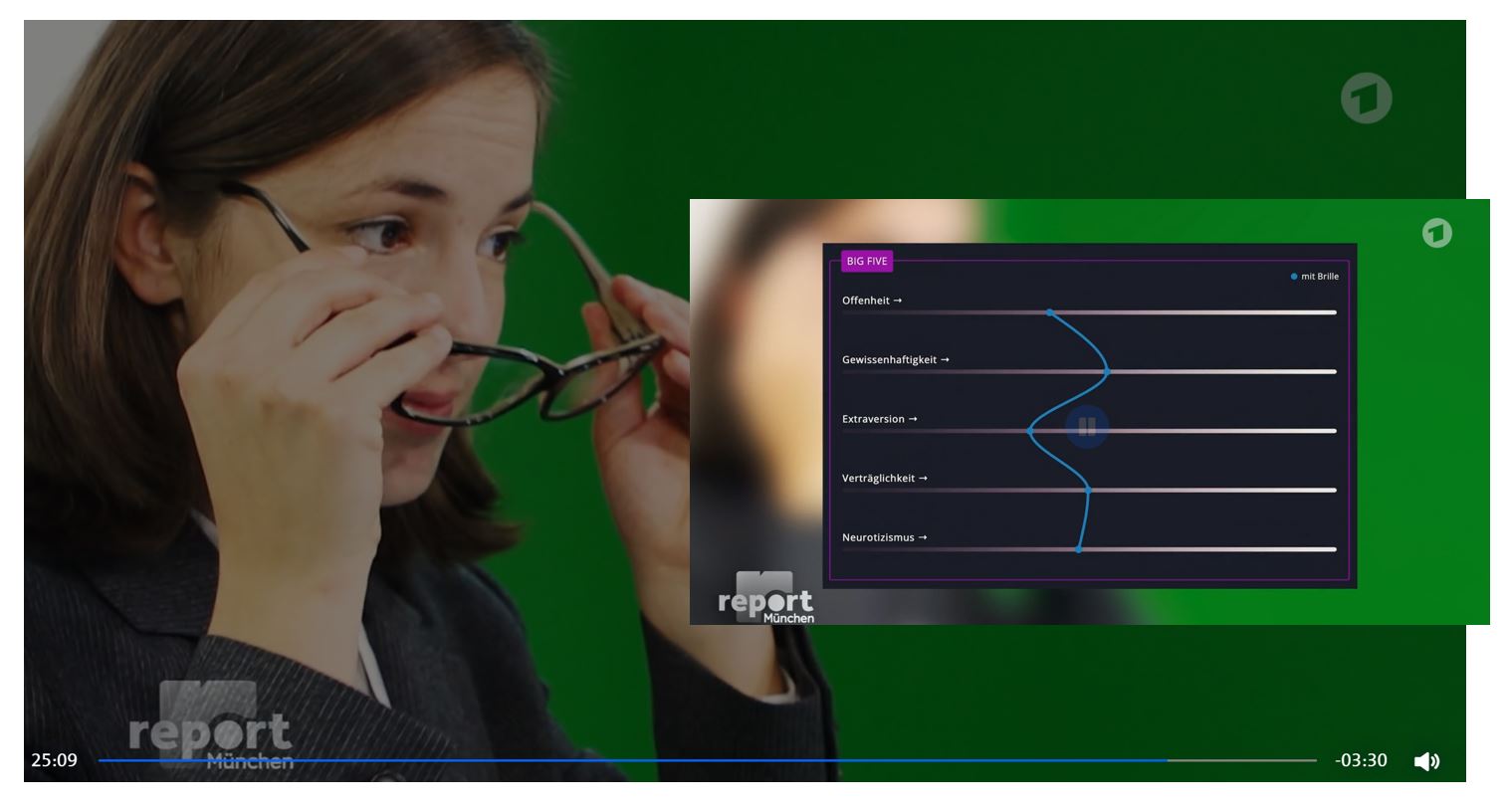

Und gestern ging nun ein anderes sehr spannendes umfangreiches Experiment durch die einschlägigen Timelines. Hierbei probierte ein Team des BR die KI-basierte Analysesoftware des Münchner Startups retorio aus und zwar so, dass diese Videos von Bewerbern auf deren Persönlichkeit untersuchte. Das besondere daran: Es handelte sich dabei um Videos ein und derselben Person, bei der aber immer einzelne Merkmale verändert wurden: Mal bekam die Person eine Brille auf, mal ein Kopftuch. Auch wurde der Hintergrund von ansonsten identischen Videos variiert: Mal ein Bild an die Wand gehängt, mal ein Bücherregal im Hintergrund eingeblendet. Und schließlich wurde auch mit der Bildqualität gespielt, z.B. durch veränderte Beleuchtungsbedingungen.

Das Resultat?

Den Personen wurde durch die KI jedes Mal eine andere, teilweise stark abweichende Persönlichkeit attestiert…

Ich will das jetzt hier nicht 1:1 alles wiederkäuen, empfehle aber dringend jedem, der sich mit dieser Thematik beschäftigt oder beschäftigen sollte (also eigentlich alle PersonalerInnen), sich den Bericht „Fairness oder Vorurteil„ einmal durchzulesen oder den dazugehörigen Beitrag von report MÜNCHEN einmal anzusehen.

Macht nachdenklich…

Auf jeden Fall hat sich HireVue in den USA mittlerweile wohl davon verabschiedet, zu versuchen, Persönlichkeit aus äußeren Merkmalen abzuleiten. Precire hat wohl gar komplett aufgegeben. Es scheint Gründe zu haben…

Wer noch ein wenig tiefer in das Thema einsteigen will und verstehen möchte, was eigentlich das Problem der Maschinen bei der Mustererkennung ist, dem empfehle ich erstens den folgenden Artikel…

KI-Gesichtserkennung findet Waldo. Erkennt sie auch Persönlichkeit?

…und der kann sich schon mal auf die nächste Ausgabe der Zeitschrift für das Recht der Wirtschaft freuen, die dieses Thema ebenfalls (auch aus rechtlicher Sicht) in den Blick nimmt.

Die lebhafte Diskussion dazu ist auf jeden Fall in vollem Gange. Steigt gern ein…

Jetzt muss es doch auch der letzte KI-Guru im HR verstanden haben! :-)

Geld lieber in Naturschutz und echte Menschen investieren.

KI dort einsetzen wo sinnvoll! Energie-Grid. Medizin. Logistik. Katastrophenschutz.

Habe die Ehre.

Jetzt geht das KI-Bashing wieder los. Ein kurzer Blick auf Retorios Website zeigt, dass deren Technologie Persönlichkeitswahrnehmung beurteilt, die natürlich je nach Verhalten und Kontext abweicht. Zudem scheint die Firma lediglich eine Zweiteinschätzung auf Videointerviews zu geben. Der BR erwähnt das alles nicht, gibt aber selbst an, dass man die KI nicht systematisch überlisten konnte.

Es scheint mir so, als hätte man die KI mit hunderten von Videos bombardiert und dann ein paar Ausreißer, wie es sie in diagnostischen Verfahren immer gibt, zur Story gemacht.

Viel interessanter wäre doch gewesen, wie Menschen die Personen in den Videos im Vergleich zur KI beurteilt hätten! Mein Verdacht -> der Mensch wäre schlechter weggekommen.

Bei den aktuellen Diskriminierungsstatistiken, die wir in Deutschland im HR beobachten, könnte man neuen Technologien durchaus eine Chance geben. Klar sind Maschinen nicht perfekt, Menschen aber auch nicht. -> warum nicht einfach verschiedene Verfahren kombinieren, um mehr Objektivität in den Prozess zu bekommen (das scheint ja hier der Ansatz zu sein).

We Need Laws to Take On Racism and Sexism in Hiring Technology

https://www.nytimes.com/2021/03/17/opinion/ai-employment-bias-nyc.html

#DenkenFirst #TechSecond