*****

Diesen Artikel als Podcast hören? Hier entlang…

Diesen Artikel als Podcast hören? Hier entlang…

*****

Nein, das hier soll noch gar kein richtiger Jahresrückblick werden, aber so viel dürfte jetzt schon feststehen: Eines der meistdiskutierten Themen des Jahres 2019 war sicherlich der Einsatz von künstlicher Intelligenz in der Personalgewinnung. Das war zwar im letzten Jahr auch schon so, aber dieses Jahr hat die Diskussion einen ganz besonderen und wichtigen Twist bekommen:

Es wurde viel mehr über die Folgeabschätzungen und die ethischen Dimensionen des Themas gesprochen. Zahlreiche Veranstaltungen – große Leitveranstaltungen wie die Zukunft Personal, der RC19 oder das Trendence Festival, genauso wie snackable Events (etwa verschiedene HRTech-Nights oder der DUB ThinkTank) – drehten sich vor allem um die Fragen:

Was tut KI eigentlich? Und was sollte sie überhaupt (nicht) tun?

Welchen Regeln folgen Algorithmen und KI und nach welchen Regeln sollen diese bewertet werden? Was ist erlaubt, was nicht? Wo liegen überhaupt Risiken und sind eigentlich alle Risiken gleich groß?

So erschien dieses Jahr das in dem Zusammenhang sehr empfehlenswerte Buch “Ein Algorithmus hat kein Taktgefühl” von Prof. Katharina Zweig – ich hatte im Oktober etwa das von ihr vorgeschlagene System zur Risikoklassifizierung von automatisierten Entscheidungssystemen ja bereits einmal vorgestellt.

Und vor ein paar Wochen stellten die Stiftung Neue Verantwortung und die Bertelsmann Stiftung in Berlin den vorläufigen Abschluss des Forschungsprojekts “Algorithmen für das Gemeinwohl” vor, zu dem ich einen kleinen Beitrag beisteuern durfte.

Im Rahmen der Abschlussveranstaltung am 21.11. in den Räumen der SNV an der Berliner Freiheit führte die Projektleiterin Leonie Beining ein sehr erhellendes Interview mit dem KI-Experten Dr. Andreas Dewes. Der Data Scientist hat mit seinem Team eine Open-Source Software zur Kontrolle von algorithmischen Entscheidungssystemen (ADM) entwickelt, welche die Funktionsweise solcher Systeme transparent und besser nachvollziehbar machen soll. In dem Hintergrundgespräch wurde verdeutlicht, dass es für verschiedene Zielgruppen unterschiedliche Werkzeuge braucht, damit ADM für sie nachvollziehbar werden, und was die Herausforderungen bei der Erklärung komplexer Machine-Learning-Modelle sind. Es wurde klar, dass es zukünftig darum gehen muss, Themen wie Nachvollziehbarkeit konsequent in der Ausbildung von Entwickler_innen zu verankern und die akademische Forschung in dem Bereich stärker in die Unternehmen zu tragen, die ADM entwickeln und anwenden. Das Gespräch wurde transkribiert und kann hier nachgelesen werden.

Auch wenn also die letzten Beiträge hier im Blog ausnahmsweise mal vergleichsweise wenig mit Algos und KI zu tun hatten, heißt das nicht, dass es um das Thema ruhiger geworden ist. Ich habe nur Material gesammelt… ;-)

Warum ist die Ethik von automatisierten Entscheidungen denn eigentlich so wichtig?

Nun, erstens weil sie uns diese Entscheidungen alle betreffen: Wenn uns Google ein Restaurant empfiehlt oder uns das Navi einen anderen Weg als normal fahren lässt, aber eben auch wenn wir nach einem Job suchen oder uns auf einen bewerben.

Jetzt könnte man natürlich sagen, dass es gegen unerwünschte Auswüchse und nicht zulässige Entscheidungen ja bereits mehr oder weniger wirksame Regulierung gibt. So schützen etwa das AGG vor Diskriminierung oder der Beschäftigtendatenschutz in §26 BDSG-neu iVm. der DSGVO vor “nicht-erforderlichen” Auswahlmethoden.

Ja, stimmt. Aber was für einen Schutz soll das AGG bieten, wenn es für den Betroffenen überhaupt nicht klar ist, dass, auf welcher Grundlage und über welchen Weg ein automatisiertes Entscheidungssystem zu einer Entscheidung gelangt ist? Oder was bringt das juristische Konstrukt “Erforderlichkeit”, wenn deren Nachweis oder Widerlegung die fachlich-methodischen Kompetenzen der Betroffenen (und deren Vertretern, Anwälten, Betriebsräten etc.) weit übersteigt?

Und klar, man kann auch argumentieren, dass ja auch Menschen diskriminieren.

Stimmt natürlich ebenfalls. Ich wäre der letzte der behaupten würde, dass es etwa um die Qualität von Personalauswahlentscheidungen insgesamt so richtig gut bestellt wäre.

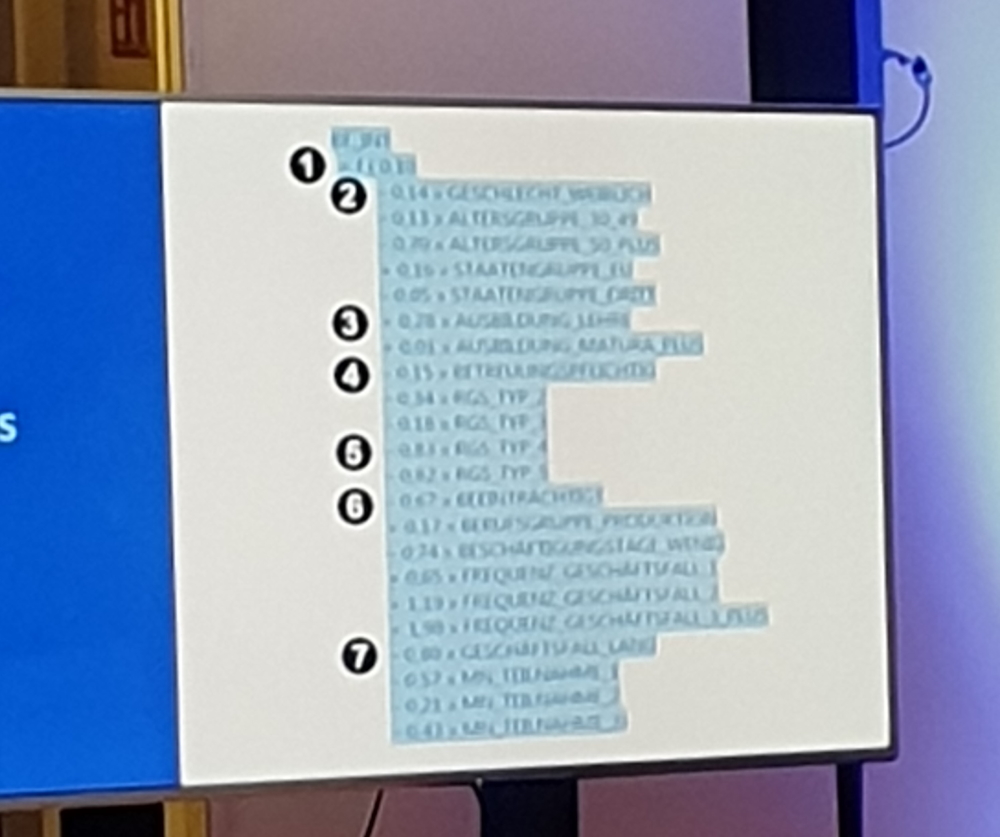

Aaaber: Der Wirkungsradius einer menschlichen Entscheidung ist zumeist erheblich geringer. Der Recruiter, der keine Frauen einstellt, der diskriminiert im Rahmen seines Aktionsraums = den Bewerber_innen, die er (nicht) einstellt. Ein Algorithmus, der alle Bewerber_innen eines Unternehmens screent und dabei systematisch Frauen schlechter bewertet, greift erheblich weiter um sich. Zudem: Entscheidungen, die in automatisierten Entscheidungssystemen getroffen werden, verstecken sich oft in sehr komplexer Mathematik. In manchen Fällen, wie etwa dem Bewertungssystem, mit der der österreichische AMS Arbeitslose bewertet, ist das noch recht einfach nachvollziehbar – Frauen und Alte bekommen einfach einen “Malus”, EU-Bürger einen Bonus…

…aber was, wenn es sich um ein lernendes neuronales Netz handelt? Die getroffenen Entscheidungen bauen hier auf vorher – ebenfalls vom System selbst – getroffenen Entscheidungen auf. Das Spiel von Trial and Error, das Anpassen von Gewichtungen der Neurons, das Hinzufügen und Löschen von Verbindungen usw. geschieht hier in Windeseile und ist oft gar nicht mehr wirklich sinnvoll rückwärts abzuwickeln. Am Ende steht eine Entscheidung, die mehr oder weniger niemand mehr so richtig erklären kann. Und selbst wenn die getroffene Entscheidung am Ende nach objektiven Maßstäben sogar “richtig” gewesen sein mag, heißt das ja noch lange nicht, dass diese auch “gewollt” ist.

Und nein, das alles sind keine berufspessimistischen Dystopien technologiefeindlicher Kreise. So forderten kürzlich die KI-Experten des AI Now Institute der New York University zunächst ein Moratorium und anschließend einen engen gesetzlichen Rahmen für den Einsatz von KI, die Gesichtserkennung zur Emotionserkennung einsetzt. Wer jetzt an eben genau diesen Einsatz von KI in der HireVue-Technologie denken muss, der liegt richtig. Genau gegen solche Einsatzformen richtet sich die Forderung…

Algo-Ethik als Wettbewerbsvorteil

Aber nicht nur die Tatsache, dass wir alle von den Auswirkungen algorithmisch getroffener Entscheidungen betroffen sind, gibt dem Thema Relevanz. Nein, auch aus unternehmerischem Interesse werden Transparenz und Algo-Ethik immer wichtiger.

So konnte eine Untersuchung von Capgemini kürzlich aufzeigen, dass Ethik beim Einsatz von KI immer mehr zum Wettbewerbsfaktor wird. Oder mit anderen Worten: Unternehmen können sich einen Vorteil verschaffen, wenn auf ethische Prinzipien beim Einsatz von algorithmischen Entscheidungssystemen besonderes Augenmerk legen. Ein paar der Ergebnisse:

- 62% der Verbraucher sagen, es stärke ihr Vertrauen in das Unternehmen

- 61% teilen ihre positiven Erfahrungen mit ihrem Umfeld (Familie, Freunde etc.)

- 59% fühlen sich dem Unternehmen loyaler verbunden

- 55% kaufen mehr Produkte des Unternehmens

- 55% äußern sich positiv über das Unternehmen (z.B. über Bewertungen ab Empfehlungen in Social Media)

Zu ganz ähnlichen Aussagen kommt eine Studie des BVDW:

74% der Deutschen geben an, dass Ethik bereits bei der Produktentwicklung einen hohen oder sehr hohen Stellenwert haben sollte. Bei den Unternehmen sind es weniger aber mit 55% immer noch mehr als die Hälfte. 72% der Verbraucher würden Produkte oder Services bevorzugen, deren Entscheidungsfindung sich an nachvollziehbaren ethischen Standards orientiert. Interessant: Auch 71% der befragten Digitalunternehmen glauben, dass derartige Lösungen am Markt erfolgreicher sind.

Das bedeutet auch: Die Akzeptanz gegenüber einer getroffenen Entscheidung steigt, wenn diese als fair und angemessen wahrgenommen wird. Und zwar auch dann, wenn es letztlich eine negative Entscheidung ist, etwa die Absage in einem Recruitingprozess. Das ist übrigens ein Befund, den wir aus nahezu zwei Jahrzehnten Einsatz von Online-Assessment-Verfahren mit jährlich mehreren Hunderttausend Testdurchführungen definitiv bestätigen können: Wenn ein Testkandidat versteht, was mit ihm gemacht wird und warum, dann akzeptiert er auch, dass andere möglicherweise den Vorzug erhalten haben.

Man sollte also meinen, die KI einsetzenden Unternehmen haben ein Eigeninteresse daran, ethische Grundsätze hochzuhalten. Aber werden Sie es deshalb auch tun?

Nun, man kann da durchaus seine Zweifel haben. Ich glaube hier allein auf Reinigungskräfte des Marktes zu hoffen, wäre doch etwas zu idealistisch gedacht. Es wird mE. am Ende gar nicht anders gehen, als einen regulatorischen (gesetzlichen) Rahmen vorzugeben.

“KI-Observatorium” und Novelle des BetrVG?

In diesem Zusammenhang sind die aktuellen Bestrebungen des Bundesministeriums für Arbeit und Soziales sehr interessant. Dort wird ggw. ein sog. “KI Observatorium” eingerichtet (späterer Ausbau zum Bundesinstitut geplant), das eben für mehr Transparenz solcher algorithmenbasierten Bewertungs- und Entscheidungssysteme (ADM) sorgen soll. Bis hin zu ausgesprochenen Verboten – wie dies unter anderem auch die von der Bundesregierung eingesetzte Datenethikkommission gefordert hat. Ferner ist für 2020 eine Novelle des Betriebsverfassungsgesetzes geplant, die die Mitbestimmung auf KI / ADM ausweiten soll.

Ich glaube die unlängst mit sehr viel Schaum vor dem Mund geführte “Diskussion” um Mitarbeiterbewertungssysteme wie ZONAR von Zalando (hier ein paar rechtliche Ausführungen dazu) zeigt, dass es hier sowohl gewisser Spielregeln, der Möglichkeit zur Überprüfung, ob diese eingehalten werden, sowie entsprechender Sanktionsmöglichkeiten bedarf.

Studie “Diskriminierungsrisiken durch Verwendung von Algorithmen”

Überaus spannend ist vor diesem Hintergrund die kürzlich veröffentlichte Studie “Diskriminierungsrisiken durch Verwendung von Algorithmen“.

Herausgegeben wurde diese durch die Antidiskriminierungsstelle des Bundes und verfasst durch Dr. Carsten Orwat vom Institut für Technikfolgeabschätzung und Systemanalyse (ITAS) am Karlsruher Institut für Technologie (KIT).

Die Studie kann hier heruntergeladen werden und diese in Gänze zu lesen ist absolut empfehlenswert. Neben Diskriminierungsgefahren in anderen Bereichen wie etwa der Medizin, der Strafverfolgung, der Kreditwirtschaft oder im Handel ist einer der Schwerpunkte der Studie explizit das “Arbeitsleben” (Kapitel 4.1., S. 34ff.).

Behandelt werden z.B. Algorithmen zur Einteilung von Arbeitslosen (etwa des österreichischen AMS wie oben schon zitiert oder des polnischen Arbeitsministeriums). Auch “Klassiker” wie das von 2014 bis 2017 bei amazon eingesetzte (und dann aufgrund notorischer Unverbesserlichkeit eingestellte) System zur Bewertung von (potentiellen) Bewerber_innen fehlen natürlich nicht.

Die Beispielsammlung lenkt den Blick aber auch auf vergleichsweise verbreitete und auf den ersten Blick eher “harmlose” Methoden. Wer etwa über Facebook microgetargete Stellenanzeigen schaltet und dabei (ggf. sogar unwissentlich) bestimmte Alters- und Geschlechtergruppen ausschließt, macht sich so möglicherweise schon der algobasierten Diskriminierung schuldig. Und das kann durchaus sehr “mittelbar” passieren, etwa wenn Gruppen mit ins Targeting einbezogen werden, die einen Schluss auf Geschlecht, Ethnie oder Alter zulassen (“Soccer Dads”, “Working Moms”) oder wenn das Feature der sog. Lookalike Audiences genutzt wird.

Das bedeutet auch Tools, die automatisiert Stellenanzeigen über Social Media ausspielen und diese Ausspielung fortlaufend (automatisiert) optimieren (etwa der großartige Jobspreader von Wollmilchsau) müssen den Nachweis erbringen können, nicht zu diskriminieren.

Algo-Ethik wird uns ganz sicher noch intensiv beschäftigen

Ja, wie eingangs gesagt: Das hier ist ganz sicher kein Jahresrückblick. Das Thema Algo-Ethik hat uns in 2019 intensiver angefangen zu beschäftigen und es sind neben den hier im Text genannten Initiativen ja noch einige weitere sehr begrüßenswerte ins Rampenlicht getreten – ich nenne hier nur mal den für HR im Speziellen einschlägigen Ethikbeirat HR-Tech -, aber die Geschichte ist ja mit dem Jahr 2019 noch nicht zu Ende erzählt. Nein, eines ist ganz sicher: Auch 2020 wird dazu einiges bereithalten.

Nehmt diesen Beitrag daher gern als Jahresausblick…