Soll eine Maschine mir Vorschläge machen, wo ich abends in einer fremden Stadt Essen gehen könnte? Ich nehme an, die meisten würden jetzt sagen ja, warum nicht?

Soll eine Maschine entscheiden dürfen, ob eine lebenserhaltende Maßnahme, z.B. eine künstliche Beatmungsmaschine, abgeschaltet wird und ein Mensch stirbt? Hier würden wohl die meisten entsetzt den Kopf schütteln.

Und wie sieht es bei Entscheidungen aus, deren Tragweite vielleicht nicht “Leben oder Tod” heißt, die aber dennoch deutlich weiter reichende Konsequenzen haben als “das Essen hat nicht geschmeckt”? Entscheidungen wie etwa die Zu- oder Absage eines Bewerbers oder die Beförderung oder Nicht-Beförderung eines Mitarbeiters.

Es ist wenig verwunderlich, dass genau solche Fragen der “Algo-Ethik” zunehmend ins Zentrum der Diskussion um sog. “Algorithmische Entscheidungssysteme” rücken. Und da der Einsatz solcher Instrumente auch und ganz maßgeblich im Kontext der Personalgewinnung, -auswahl und -bewertung diskutiert wird, spielt dieses Thema (manchmal verkürzt unter dem Schlagwort “KI”) auch hier im Blog seit einigen Jahren eine sehr große Rolle. Naja, wenn CYQUEST Anfang nächsten Jahres Geburtstag feiert, dann werden wir uns ja selber seit zwei Jahrzehnten mit der Entwicklung von Algorithmen beschäftigt haben, die dem Zweck der Personalgewinnung, -auswahl und -bewertung dienen. Von daher ist es wohl nicht nur naheliegend, sondern beinahe unsere Pflicht, uns auch mit entsprechenden Technologiefolgeabschätzungen zu befassen.

Aber das tun natürlich Gott sei Dank auch noch einige andere.

So erschien am Freitag in der Reihe Handelsblatt Disrupt ein wunderbarer Podcast des Handelsblatt Digitalchefs Sebastian Matthes, in dem dieser ein Interview mit Katharina Zweig, Professorin für Graphentheorie und Analyse komplexer Netzwerke an der TU Kaiserslautern und eine der führenden “KI-Expertinnen” Deutschlands, führt.

Ich möchte euch diesen Podcast wirklich wärmstens ans Herz legen (das Gespräch ist ca. 30 Minuten lang) – hier direkt beim Handelsblatt, hier bei Apple Podcasts. Da ich aber weiß, dass das mit dem Hören von Podcasts immer so eine Sache ist (wann hat man denn mal die Zeit und Muße und zudem noch Kopfhörer auf, um nicht allen um einen herum damit auf die Nerven zu gehen…? ;)), habe ich nachfolgend zwei Dinge noch einmal gesondert herausgegriffen, die man auch einfach durch “stilles Lesen” konsumieren kann:

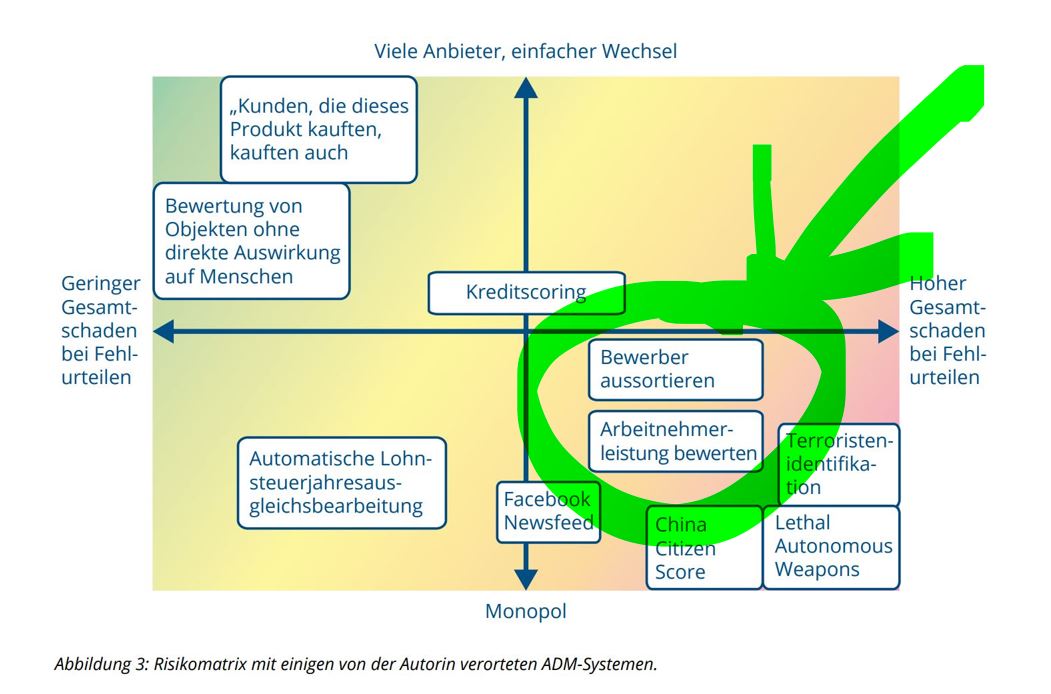

Erstens: Katharina Zweig referenziert auf ein Modell, mit dessen Hilfe Algorithmische Entscheidungssysteme hinsichtlich ihres jeweiligen Risikos klassifiziert werden können, um darauf aufbauend dann auch besser festlegen zu können, welche mehr oder weniger strengen Anforderungen (z.B. hinsichtlich Transparenz, Nachvollziehbarkeit, Verantwortlichkeit und Ausmaß an zu erfüllender Subjektqualität) jeweils gelten sollen.

Ich könnte das jetzt episch lang rezitieren, muss ich aber nicht, denn das hat sie selber alles sehr schön kompakt aufgeschrieben (nachzulesen hier bei der Konrad-Adenauer-Stiftung) bzw. folgende Abbildung fasst das Modell bereits sehr schön zusammen:

Zweitens (denn wir sind hier ja ein Blog, der sich in erster Linie Fragen der Personalgewinnung widmet) habe ich ein wie ich finde sehr schönes Zitat von Katharina Zweig aus dem Podcast herausgegriffen, das konkret Algorithmen zur Bewertung von Bewerbern und Mitarbeitern in diese “Risikomatrix” einsortiert:

>>Wenn es um etwas wirklich Relevantes geht, da müssen wir reingucken können. Zum Beispiel Bewerberbewertung oder interne Bewertung von Kandidaten in Firmen. Solche Fälle müssen dringend nachvollziehbar sein.

Weil wenn einer Person zehn Jahre der Aufstieg in die nächste Management-Ebene verwehrt wird, aufgrund einer maschinellen Entscheidung, dann muss diese Person und der Betriebsrat, der sie vertritt, nachvollziehen können, warum das der Fall ist und ob das aus gerechtfertigten Gründen oder nicht gerechtfertigten Gründen passiert. Das ist eine schwerwiegende Entscheidung mit einem hohen Schadenspotenzial, nämlich das Potenzial der Diskriminierung, und die ist gesetzlich verboten. Und diese Person ist der Entscheidung so stark ausgesetzt, denn die Firma kann man nicht mal so eben wechseln, dass wir da tatsächlich als regulative Anforderung ein nachvollziehbares maschinelles Lernen voraussetzen müssen.

Wenn es aber um etwas geht, das kein so hohes Schadenspotenzial hat, dann ist es mir auch egal, ob die Maschinen mir erklären kann, warum das jetzt besser ist oder nicht.<<

Oder um auch das in einem Bild zusammenzufassen:

Insofern ist es gut, dass etwa die DSGVO iVm. §26 BDSGneu schon einen gesetzlichen Rahmen dafür bietet, was geht und was nicht, nämlich indem sich hier die Anforderung der sog. “Erforderlichkeit” findet. Damit kann man ja schon mal ganz gut arbeiten…