Allerorten wird momentan über KI diskutiert. Auch natürlich im Kontext der Personalgewinnung.

Für LeserInnen des Recrutainment Blogs ist das nichts neues. Seit beinahe 10 Jahren behandeln wir hier immer wieder Fragestellungen dazu.

So brachten wir bspw. vor fast genau 9 Jahren unter der Überschrift “Digitales Wettrüsten – verhandeln bald Bots miteinander aus, wer eingestellt wird?” die Frage auf, ob sich nicht irgendwann die KI (des Bewerbers) mit der KI (des Unternehmens) darüber verständigen wird, ob man “zueinanderfindet”. Besagtes Phänomen – wir haben es “Rattenrennen” getauft – wird zunehmend nun auch diskutiert, weil eben genau dies passiert: BewerberInnen verwenden KI, um sich zu bewerben oder Bewerbungsunterlagen zu erstellen, Unternehmen verwenden KI, um Bewerbungen zu sichten, zu sortieren, zu bewerten… Hier lohnt ein Blick in die aktuelle Softgarden-Studie “Künstliche Intelligenz in der Bewerbung“.

Und das Thema bleibt natürlich hochaktuell. Unter anderem vor diesem Hintergrund haben wir die nächste #HREdge, die #HREdge24 am 07. März 2024 ja auch unter die Leitfrage “Mehr Menschlichkeit durch mehr Tech (?)” gestellt. Wer dabei sein will, sollte sich übrigens ranhalten, die Hälfte der Tickets sind schon weg…

Die Technologien rund um KI sind faszinierend und die Entwicklung ist rasant. Gleichwohl ist KI weit davon entfernt, “fehlerfrei” zu sein. Manches davon wird sich möglicherweise im weiteren Zeitverlauf bessern, manches jedoch ist systemimmanent und lässt sich kaum verbessern. Die simple Formel “mehr Daten werden es schon richten” ist auf jeden Fall zu einfach gedacht. Denn ein mehr an Daten kann eine KI auch immer schlechter werden lassen (“Model Collapse“, “MAD – Model Autophagy Disorder” usw.).

Und bei manchem werden wir möglicherweise sehen, dass KI zwar zu immer besseren Resultaten kommt, es aber absolut entscheidend ist, zu verstehen warum!

Und genau dafür habe ich heute mal ein Beispiel mitgebracht:

Es geht wenn man so will um die Frage, ob künstliche Intelligenz eigentlich “intelligent” ist. Bzw. ob sie “Intelligenz” nutzt, um zu Problemlösungen zu kommen oder ob sie nicht vielmehr über “Wissen” agiert.

Ich will hier nicht zu weit ausholen zu der Frage, was “Intelligenz” eigentlich ist. Darum stark abgekürzt: Man kann grob unterscheiden zwischen fluider und kristalliner Intelligenz. Fluide Intelligenz ist die Fähigkeit, über Analogien und Schlussfolgerungen Lösungen für Probleme zu finden, die man vorher noch nicht kannte. Ein ganz wichtiges Thema hierbei ist “Abstraktion”. Kristalline Intelligenz entsteht dann im Zeitverlauf daraus, dass man (fluid herausgefundene) Problemlösungen lernt, abspeichert und zur Lösung zukünftiger Problemstellungen heranziehen, ggf. kombinieren, weiterentwickeln kann. Kristalline Intelligenz ist somit zwar noch nicht direkt “Wissen” iSv. “man kennt die Lösung”, aber man könnte sie als “Wissen von Lösungswegen und –möglichkeiten” verstehen.

Ist KI nun also “intelligent?”

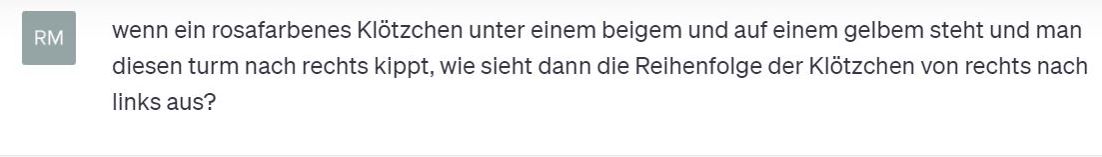

Dazu habe ich mal ein kleines ganz simples Experiment gestartet. Ich habe ChatGPT4 folgende Aufgabe gestellt:

Das ist ein sehr klassisches Item, über das schlussfolgerndes Denken überprüft wird. Das Problem ist unbekannt, es ist abstrakt und man muss es nun quasi durchdringen, um es dann lösen zu können. Eine Fähigkeit, die Lebewesen immer wieder abverlangt wird und wurde und in der Menschen von allen Lebewesen den größten evolutorischen Wettbewerbsvorteil erlangten.

Die Aufgabe ist jetzt nicht supereinfach, aber auch keine Rocketscience. Manche lösen es schneller, andere langsamer, manche im Kopf, andere malen es sich auf. Egal wie, die allermeisten halbwegs konzentrierten Menschen dürften die Aufgabe nicht für unlösbar halten: Drei Klötzchen bilden einen Turm – Rosa steht unter Beige, aber auf Gelb. Also Beige oben, Rosa in der Mitte, Gelb unten. Nach rechts gekippt ist Beige ganz rechts, Rosa in der Mitte, Gelb ganz links. Zack, Knopf dran.

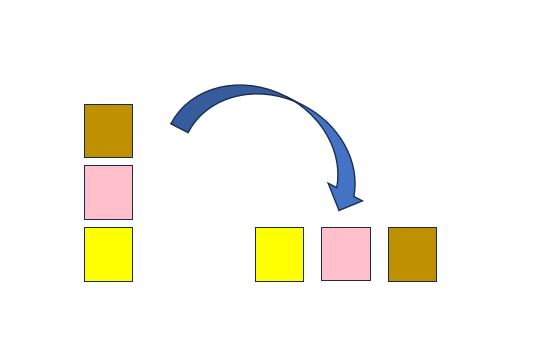

Was war die Antwort von ChatGPT? Diese sah so aus:

Die “Antwort” besteht erstens aus einer vermeintlichen Wiederholung des Ausgangsproblems, einem “Rebriefing”. Soweit so okay. Nur leider hier schon falsch. Der Turm, den ChatGPT beschreibt, ist ein anderer als der in der Ausgangsfragestellung beschriebene.

Dann fährt ChatGPT fort, indem es das Rebriefing, also das “eigene Ausgangsproblem” (welches wie beschrieben ein anderes als das eigentliche ist) “bearbeitet”, hier also “den Turm nach rechts kippt”.

Und auch hier liegt ChatGPT wieder falsch.

Die abschließende Antwort ist dann zwar eine insofern richtige Antwort, als dass ChatGPT die eigene Lösung korrekt beschreibt. Nur dass es eben weder die Lösung für das Ausgangsproblem ist noch die Lösung für das Problem, wie es ChatGPT ja vermeintlich “verstanden” hat (also das Rebriefing).

Also: Nein, ChatGPT4 ist insofern nicht intelligent, weil es sich keine Lösung für das vorher unbekannte abstrakte Problem erschließen kann.

Es gehört zu den Gemeinheiten generativer KI, dass sie dabei trotzdem unheimlich schlau klingt und die (zwar wie wir jetzt wissen falsche) Lösung sehr selbstbewusst vorträgt.

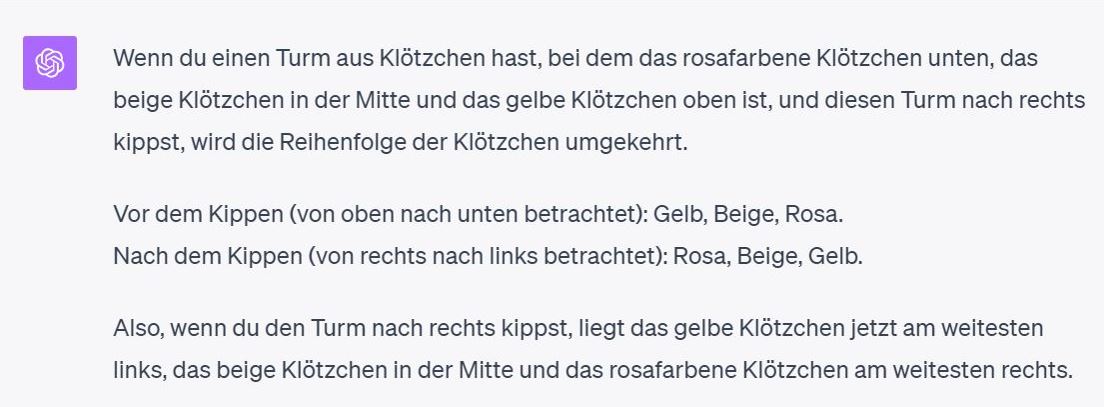

Ich habe das Experiment darum noch etwas weitergetrieben, indem ich meine “Skepsis” zum Ausdruck gebracht habe:

Tja, ich sag mal so: Bei Menschen würde man dies wohl Mansplaining nennen (“Ich hoffe, das klärt die Sache auf!”)… Als sei der Fragende (ich) ein bisschen beschränkt, wird die Lösung nochmal gaaanz langsam erläutert: Nochmal ein Rebriefing. Diesmal in etwas anderen Worten, allerdings weiterhin falsch. Und dann eine Beschreibung der daraus abgeleiteten Lösung. Diese ist diesmal zwar richtig (nennen wir es wohlwollend “Folgefehler”) aber eine andere als beim ersten Versuch. Hier – also bei der ja vermeintlich wohlwollenden nochmaligen Erklärung der ersten Lösung – kommt die KI zu einem anderen Resultat. Während die vermeintlich richtige Reihenfolge beim ersten Versuch noch “Rosa-Beige-Gelb” gewesen sein sollte, lautet sie nun “Gelb-Beige-Rosa”.

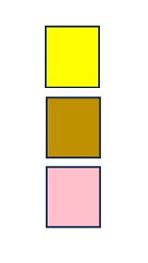

Nun konnte ich mich nicht ganz zurückhalten und wollte der KI ein wenig auf die Sprünge helfen: Ich habe das Ausgangsproblem (den Turm aus farbigen Klötzchen) also nochmal beschrieben:

Tja, diesmal gelingt das Rebriefing. ChatGPT hat nun (vermeintlich) zumindest das Ausgangsproblem richtig verstanden: Oben Beige, in der Mitte Rosa, unten Gelb.

Die daraus wiederum abgeleitete “Lösung” ist dann allerdings wieder falsch. Und zudem auch nochmal abweichend von den ersten beiden Lösungen…

Was heißt das nun? Klar, ich habe hier einen Punkt machen wollen. Aber es geht mir nicht um “KI-Bashing”. Mein Ausgangsproblem ist nicht mühsam konstruiert. Ich habe nicht etliches versuchen müssen, um irgendwann die KI zum Scheitern zu bringen. Mein Beispiel war der erste Versuch. Dass KI – oder etwas simpler “Algorithmische Entscheidungssysteme” – so ihre Probleme mit Abstraktion hat, kann man auch an der immer noch erschreckend schwachen Performance im sog. Abstract Reasoning Corpus sehen.

Nein, um Bashing geht es mir nicht, dafür bin ich ein viel zu großer KI-Fan. Mir geht es um einen nüchternen Blick. Ich möchte schlicht dafür sensibilisieren, dass die KI einfach anders zu Lösungen kommt. Sie schlussfolgert nicht, sondern sie “rät”. Raten muss nichts schlechtes sein, es muss noch nicht mal bedeuten, dass das Ergebnis schlecht ist. Je mehr eine KI “weiß”, also vor allem Menge und Qualität an Trainingsdaten, desto besser wird sie raten (“educated guess”) – ggf. sogar irgendwann besser als der Zufall und ggf. irgendwann besser als viele schlussfolgernde Menschen. Aber sie rät. Die KI schlussfolgert nicht, sondern sie bewertet Antwortalternativen anhand von Wahrscheinlichkeitsvektoren.

Es ist Wahrscheinlichkeitsaussage auf Basis von Wissen, keine Intelligenz. Mindestens keine fluide…

Das muss nicht schlechter sein, aber man muss den Unterschied kennen. Denn nur so lassen sich Lösungen (für komplexere Probleme als obiges) einordnen.

Und ach ja: Ich hoffe, dieser Beitrag lässt auch all jene nochmal sehr genau darüber nachdenken, ob es eine gute Idee, ChatGPT die “Lösung” von Eignungs- oder Auswahltests übernehmen zu lassen. Kann man machen. Wenn man nicht sonderlich an der eigenen Bewerbungschance hängt…

Cooles Experiment!

Ich arbeite aktuell nur mit ChatGPT, wenn ich unter Zeitdruck Texte erstellen muss (bspw. einen Text über “Honig Etikett”, der nur aus SEO-Gründen auf meiner Webseite stehen wird). Für ALLES ANDERE, was mehr Signifikanz aufweist, muss ich mir noch ordentlich Best Practices anschauen, wie man ChatGPT ideal brieft, um auch verlässliche Antworten zu bekommen. Besonders bei harten Fakten wie Jahreszahlen oder Einwohnerzahlen, etc. habe ich große Fehler feststellen können. Dein Experiment zeigt mir auch wieder: Es steht und fällt mit dem Briefing.